Abschlussarbeiten

Wir bieten zur Zeit 28 Bachelor- und 29 Masterarbeitsplätze an. MA-KandidatInnen müssen sich bei den jeweiligen BetreuerInnen bis zum 28.05.2023 melden. BA-KandidatInnen, die Interesse an einem Thema in der Allgemeinen Psychologie haben, kontaktieren bitte die jeweiligen BetreuerInnen. Kontaktieren Sie bitte auch eine/n von uns, wenn Sie generell Interesse an einer Arbeit in der Allgemeinen Psychologie haben, aber noch kein spezifisches Thema im Auge haben, sowie bei Rückfragen zu einzelnen Themen.

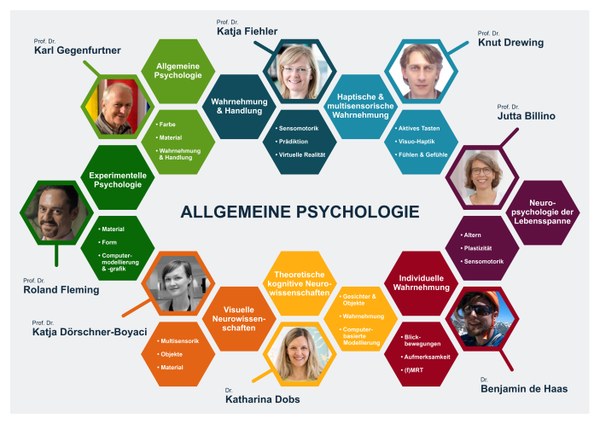

Abschlussarbeiten können in den folgenden Bereichen durchgeführt werden:

- Entwicklungsneuropsychologie von Wahrnehmung und Sensomotorik (Jutta Billino)

- Behavioral signatures of face and object recognition (Katharina Dobs)

- Perception of material qualities (Katja Dörschner)

- Haptische Wahrnehmung und visuell-haptische Interaktionen (Knut Drewing)

- Perceiving and Acting in Virtual Environments (Katja Fiehler)

- Sensorimotor predictions and control (Katja Fiehler)

- Action, perception and psychosis (Bianca van Kemenade and Katja Fiehler)

- Shape and material perception (Roland Fleming)

- Verteilung von Aufmerksamkeit und Blick beim Computerspielen (Karl Gegenfurtner und Anna Schröger)

- Kontrolle von Augenbewegungen (Karl Gegenfurtner und Alexander Goettker)

- Farbwahrnehmung in Virtuellen Welten (Karl Gegenfurtner und Raquel Gil)

- Helligkeit und Sättigung von Objekten (Karl Gegenfurtner und Laysa Hedjar)

- Farbdarstellung in der Kunst (Karl Gegenfurtner und Doris Braun)

- Individual differences in visual perception (Ben de Haas)

Entwicklungsneuropsychologie von Wahrnehmung und Sensomotorik (Jutta Billino)

|

Abweichungen von allgemeinpsychologischen Gesetzmäßigkeiten können als Fenster zu Möglichkeiten der Modulation menschlichen Erlebens und Verhaltens genutzt werden. Daher erforschen wir, wie Sensorik, Motorik, Kognition und Motivation miteinander verwoben sind und wie dieses Zusammenspiel zwischen verschiedenen Personen variiert. Bisherige Studien gliedern sich in drei Schwerpunkte: |

Bei Interesse an diesen Themen klären wir gerne die aktuellen Möglichkeiten, sich im Rahmen von Abschlussarbeiten in unsere Forschung einzubringen. Kontaktaufnahme gerne per mail: jutta.billino@psy.jlug.de |

Repräsentative Publikationen:

- Klever, L., Mamassian, P., & Billino, J. (2022). Age‑related differences in visual confidence are driven by individual differences in cognitive control capacities. Scientific Reports, 12, 6016. doi:10.1038/s41598-022-09939-7

- Hesse, C., Koroknai, L., & Billino, J. (2020). Individual differences in processing resources modulate bimanual interference in pointing. Psychological Research, 84, 440–453. doi: https://doi.org/10.1007/s00426-018-1050-3

- Klever, L., Voudouris, D., Fiehler, K., & Billino, J. (2019). Age effects on sensorimotor predictions: What drives increased tactile suppression during reaching? Journal of Vision, 19(9):9, 1-17. doi: https://doi.org/10.1167/19.9.9

- Billino, J., Hennig, J., & Gegenfurtner, K. (2016). The role of dopamine in anticipatory pursuit eye movements: Insights from genetic polymorphisms in healthy adults. eNeuro, 3(6). doi: https://doi.org/10.1523/ENEURO.0190-16.2016

Behavioral signatures of face and object recognition (Katharina Dobs)

From a brief glimpse of a complex scene, we recognize people and objects, their relationships to each other, and the overall gist of the scene – all within a few hundred milliseconds and with no apparent effort. What are the computations underlying this remarkable ability and how are they implemented in the brain? To address these questions, our lab bridges recent advances in machine learning with human behavioral and neural data to provide a computationally precise account of how visual recognition works in humans.

Faces are a ‘special’ case of visual stimuli. Numerous behavioral and neural studies of face perception have revealed several hallmarks of face perception like the face inversion effect, other-race effect or familiarity effect, while neural studies have identified and characterized a network of face-selective areas in the brain. Moreover, we detect faces faster than other visual objects, and we even see faces in things (known as ‘pareidolia’). Despite this wealth of empirical data, most theories of face perception still rely on vague word models (e.g., ‘holistic processing’), and cannot explain how the brain transforms sensory representations of a face image into an abstract representation of that face.

Here we will use behavioral measures, such as response time, face detection and recognition accuracy and eye tracking to address questions such as:

- How fast are we in extracting different face dimensions, such as gender, age or identity? And is this process affected by familiarity with a face?

- Do we process faces in things quantitatively similar to real faces?

- Is the face inversion effect unique to faces, or can we also find it for other types of objects?

In these projects, you will learn more about face perception and visual recognition in general, how to set up behavioral or eye tracking experiments and how to analyze the outcome. Further, if you like, we can teach you more about deep neural networks as models for visual perception. If you are interested, just send an email to katharina.dobs@psychol.uni-giessen.de.

[Wenn Sie mit Dr. Dobs die Aufnahme einer Abschlussarbeit in ihrer Arbeitsgruppe vereinbart haben, kreuzen Sie auf dem Wahlzettel bitte "Karl Gegenfurtner" an - wir teilen Sie dann zu]

Video zur AG von Dr. Katharina Dobs

Representative Publications:

-

Dobs, K., Isik, L., Pantazis, D., & Kanwisher, N. (2019). How face perception unfolds over time. Nature Communications, 10(1), 1258.

-

Dobs, K., Martinez, J., Kell, A., & Kanwisher, N. (2022). Brain-like functional specialization emerges spontaneously in deep neural networks. Science Advances, 8, eabl8913.

-

Dobs, K., Yuan, J., Martinez, J., & Kanwisher, N. (2023). Behavioral signatures of face perception emerge in deep neural networks optimized for face recognition. bioRxiv.

-

Kanwisher, N., Khosla, M., & Dobs, K. (2023). Using artificial neural networks to ask 'why' questions of minds and brains. Trends in Neurosciences, 46, 72-88.

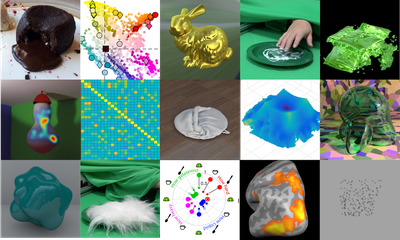

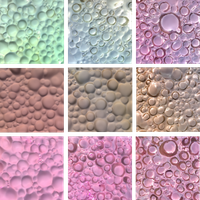

Perception of material qualities (Katja Dörschner)

Our visual experience of the world is as much defined by the material qualities of objects as it is by their shape properties: keys look shiny, a tree trunk looks rough, and chocolate soufflé looks airy. Humans can easily and nearly instantaneously identify shapes and properties of materials and adjust their actions accordingly. Yet how the perceptual system accomplishes this is largely unknown. Using a combination of psychophysics, image analysis, computational modeling, eye -/ hand tracking, and fMRI we investigate questions such as: What information does the brain use to estimate and categorise material qualities? How do expectations about materials affect how we perceive them, look at them or interact with them? Does freely interacting with a material change how it feels or looks?

If you are interested, just send an email to Katja.Doerschner@psychol.uni-giessen.de.

Representative Publications:

- Schmid, A.C., Barla, P. & Doerschner, K. (2020). Material category determined by specular reflection structure mediates the processing of image features for perceived gloss. bioRxiv, doi: https://doi.org/10.1101/2019.12.31.892083

- Schmid, A.C., Boyaci, H. & Doerschner, K. (2020). Dynamic dot displays reveal material motion network in the human brain. bioRxiv, doi: https://doi.org/10.1101/2020.03.09.983593

- Alley, L.M., Schmid, A.C. & Doerschner, K. (2020). Expectations affect the perception of material properties. bioRxiv, doi:https://doi.org/10.1101/744458.

- Schmid, A.C. & Doerschner, K. (2019). Representing stuff in the human brain. Cur. Op. Beh. Sci., 30, pp.178-185.

- Toscani, M., Yucel, E. & Doerschner, K. (2019). Gloss and speed judgements yield different fine tuning of saccadic sampling in dynamic scenes. i-Perception https://doi.org/10.1177/2041669519889070

- Ennis, R. & Doerschner, K. (2019) The color appearance of three-dimensional, curved, transparent objects.. doi: https://doi.org/10.1101/2019.12.30.891341

- Cavdan, M., Doerschner, K. & Drewing, K. (2019). The many dimensions underlying perceived softness: How exploratory procedures are influences by material and the perceptual task. IEEE World Haptic Conference. doi:https://doi.org/10.1109/WHC.2019.8816088

- Schmid, A., Doerschner, K. (2018). The contribution of optical and mechanical properties to the perception of soft and hard breaking materials. Journal of Vision, 18(1):14, 1-32.

Haptische Wahrnehmung und visuell-haptische Interaktionen (Knut Drewing)

|

Haptische Wahrnehmung ist ein aktiver Prozess, bei dem Menschen zielgerichtet Informationen aufnehmen. Wenn wir etwa erfühlen möchten, wie weich ein Objekt ist, müssen wir es zunächst in geeigneter Weise explorieren, so dass die Sensoren relevante Informationen aufnehmen. Wir untersuchen die Mechanismen der Kontrolle des Bewegungs-Wahrnehmungs-Regelkreises beim menschlichen Fühlen. Dabei gehen wir von der Hypothese aus, dass Menschen ihre Fühlbewegungen „optimal“ ausführen. Weitere Untersuchungs-schwerpunkte sind die Wahrnehmung von Weichheit, emotional-motivationale Aspekte haptischer Wahrnehmung, Zeitwahrnehmung und das Zusammenspiel von Fühlen und Sehen–etwa anhand der „Größen-Gewichts-Täuschung“. Bei Interesse vereinbaren Sie bitte einen Termin per email (knut.drewing@psychol.uni-giessen.de). |

|

Video zur AG von Prof. Dr. Knut Drewing

Repräsentative Publikationen:

- Cavdan, M., Doerschner, K., & Drewing, K. (2019). The Many Dimensions Underlying Perceived Softness: How Exploratory Procedures are Influenced by Material and the Perceptual Task. IEEE World Haptics Conference, WHC 2019 (pp. 437-442), IEEE.

- Drewing, K., Weyel, C., Celebi, H., & Kaya, D. (2018). Systematic Relations between Affective and Sensory Material Dimensions in Touch. IEEE Transactions on Haptics 11(4), 611-622.

- Kaim, L. & Drewing, K. (2011). Exploratory strategies in haptic softness discrimination are tuned to achieve high levels of task performance. IEEE Transactions on Haptics, 4. 242-252.

- Wolf, C. Bergmann Tiest, W., & Drewing, K. (2018) A mass-density model can account for the size-weight illusion. PLOS ONE 13(2): e0190624

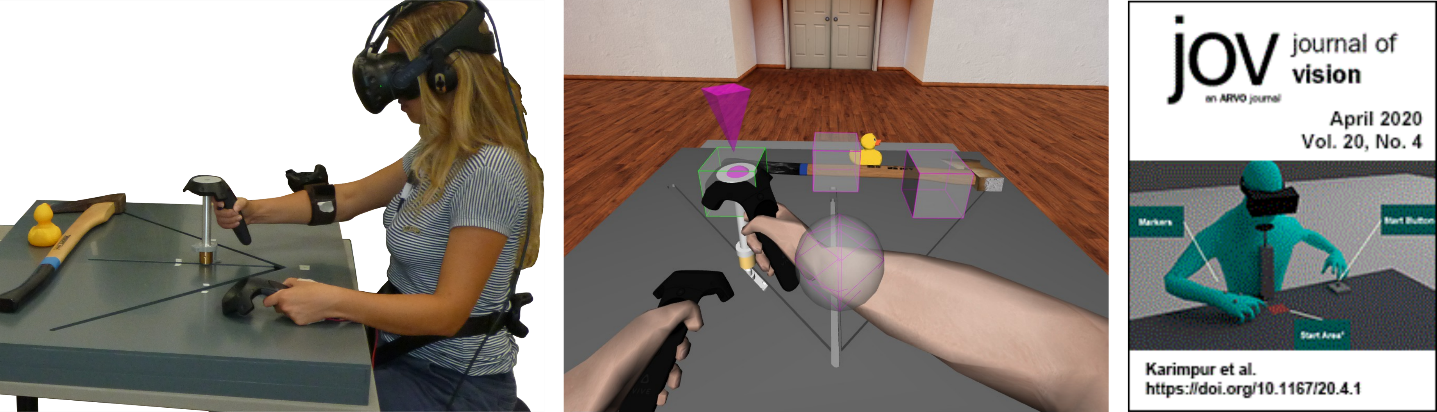

Perceiving and Acting in Virtual Environments (Katja Fiehler)

The information we perceive through our senses enable us to perform goal-directed actions. This involves the integration of our bodily senses, of objects in our environment and of information about the space we are acting in. In such a way, the actions that we perform do not only allow us to manipulate our external world, but also inform us about ourselves by providing sensory feedback. In other words: The relation between perception and action is not unidirectional, and our external world can likewise influence our perception and behaviour.

The link between perception and action has often been tested in quite abstract or limited environments. However, virtual reality (VR) as a tool allows us to create three-dimensional realistic looking environments to perform our studies in a highly controllable manner. Our research group offers different topics related to perception and action in VR. Possible research questions you could investigate with us are:

- When does a virtual body feel like ours? And can VR provoke the feeling to be in a virtual environment, rather than seeing a virtual environment?

- How do we deal with uncertainty in the world around us, for example, a suddenly appearing obstacle?

- Do distractors within or outside reach space have a different effect on our reaching behavior?

- How do the spatial and semantic properties of objects influence how we utilize them for actions, such as when looking for our keys in the living room?

Check the individual websites of our team members (https://www.uni-giessen.de/fbz/fb06/psychologie/abt/allgemeine-psychologie/wh/Team) for more information on our research! Feel free to contact any of us if you are interested in a project or if you have any questions. If you are interested, just send an email to Katja.Fiehler@psychol.uni-giessen.de.

Video zur AG von Prof. Dr. Katja Fiehler

Representative Publications:

- Karimpur, H., Eftekharifar, S., Troje, N., & Fiehler, K. (2020). Spatial coding for memory-guided reaching in visual and pictorial spaces. Journal of Vision, 20(4): 1, 1-12.

- Karimpur, H., Morgenstern, Y., & Fiehler, K. (2019) Facilitation of allocentric coding by virtue of object-semantics. Scientific Reports, 9, 6263.

- Klinghammer, M., Schütz, I., Blohm, G., & Fiehler, K. (2016). Allocentric information is used for memory-guided reaching in depth: a virtual reality study. Vision Research, 129, 13-24.

Sensorimotor predictions and control (Katja Fiehler)

Performing complex movements is a remarkably difficult task. First, humans make predictions about what will happen in the near future, which facilitates movement planning. Second, they use sensory feedback to correct any movement errors. Third, the human nervous system needs to deal with the abundance of sensory information when acting in a complex world. Interestingly, when predictions about future events are accurate, the associated sensory feedback is suppressed. This is evidenced by our inability to tickle ourselves. Like tactile sensations during self-tickling, auditory and visual sensations arising from our actions are also suppressed.

Our aim is to understand (1) the relationship between predictive and sensory feedback signals during goal-directed movements, and (2) how the processing of sensory information is shaped by predictive mechanisms and by the performed action itself. Possible research questions you could investigate with us are:

- How do humans use visual and somatosensory feedback when reaching? Do they rely more on visual information, even when this information is unreliable? Does the less reliable sensory information get stronger suppressed?

- How do humans use sensory feedback when reaching to a target that is unexpectedly displaced? When during the movement is feedback most important? Does it matter if humans reach to a visible target or to their other unseen hand?

- How does sensory suppression compare across the different phases of the movement? Is suppression a more automatic process which modulates any sensory input around the action, or is it specific to the sensory consequence arising from the action?

- How is suppression modulated when the movement leads to multiple sensory consequences? How do humans process sensory signals occurring around an action, but not arising from the action?

You will work closely with your advisor as part of an internationally vibrant group. During your project you will get the opportunity to learn how to program behavioural experiments, record arm movements and analyse behavioural and psychophysical data. If you are interested, just send an email to Katja.Fiehler@psychol.uni-giessen.de.

Video zur AG von Prof. Dr. Katja Fiehler

Representative Publications:

- Gertz H, Voudouris D, Fiehler K (2017) Reach-relevant somatosensory signals modulate tactile perception. Journal of Neurophysiology, 117(6): 2262-2268.

- Voudouris D, Broda MD, Fiehler K (2019) Anticipatory grasping control modulates somatosensory perception. Journal of Vision, 19(5): 4

- Fiehler, K., Brenner, E., & Spering, M. (2019). Prediction in goal-directed action. Journal of Vision, 19(9), 10, 1-21.

Action, perception and psychosis (Bianca van Kemenade and Katja Fiehler)

Whenever we make a movement, we generate sensory stimuli. For example, when we knock on a door, we generate both a sound and tactile input to our fingers. In a world full of sensory information, it is crucial to understand which stimuli were the consequence of our own action, and which stimuli came from the environment. The importance of this ability is illustrated by cases in which this goes wrong, such as in patients with schizophrenia who feel that their own thoughts and actions are externally controlled.

Research has shown that we make predictions about the sensory consequences of our actions, which helps us to control our movements. Furthermore, these predictions seem to affect our perception, often leading to suppression of self-generated stimuli (explaining why we can’t tickle ourselves), though sometimes action can also enhance our perception. It is thought that these predictions also help us to distinguish self-generated from externally generated stimuli.

Our aim is to understand 1) how the brain creates predictions about sensory action outcomes, 2) why action sometimes suppresses and sometimes enhances our perception, and 3) which part of these processes is altered in patients with schizophrenia, and potentially also already in healthy participants who sometimes hear voices. We perform behavioural and fMRI experiments to answer these questions.

If you are interested or have any questions, please send an email to bianca.van-kemenade@psychiat.med.uni-giessen.de

[If you would like to complete your thesis with Prof. van Kemenade, please indicate "Katja Fiehler" on the registration sheet - and we will assign you]

Video zur AG von Prof. Dr. Bianca van Kemenade

Representative Publications:

- Lubinus, C., Einhäuser, W., Schiller, F., Kircher, T., Straube, B.*, van Kemenade, B.M.* (2022). Action-based predictions affect visual perception, neural processing, and pupil size, regardless of temporal predictability. NeuroImage, 263(119601):1-13

- Uhlmann, L., Pazen, M., van Kemenade, B.M., Kircher, T., & Straube, B. (2021). Neural correlates of self-other distinction in patients with schizophrenia spectrum disorders: The roles of agency and hand identity. Schizophrenia Bulletin, 47(5):1399–1408

- Van Kemenade, B.M., Arikan, B.E., Podranski, K., Steinsträter, O., Kircher, T., & Straube, B (2019). Distinct roles for the cerebellum, angular gyrus and middle temporal gyrus in action-feedback monitoring. Cerebral Cortex, 29(4), 1520–153

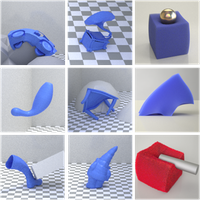

Shape and material perception (Roland Fleming)

How does the brain work out the physical properties of objects and how to guide our actions towards these objects? One important source of information about what objects are made out of – and how they respond to forces – is their shape. For example, soft materials rarely have hard corners, and rubbery materials can be bent. Shiny objects do look more or less glossy depending on their surface geometry. And where we grasp an object will depend strongly on its shape.

We are trying to understand how 3D shape and material properties interact, and how both affect behavior. The proposed projects use a combination of either (i) computer graphics and perception experiments to work out how the brain estimates the properties of objects based on shape; or (ii) real objects and grasping experiments to work out how estimations of object properties guide our actions. The thesis can be written in German or English. Possible research topics include:

- How do we work out material properties like softness or glossiness from object shape and object motion across many different simulated objects? What shape features or other sources of information is the visual system using when estimating these properties?

- How do we integrate shape and material of objects to guide our actions? How do we figure out the optimal way to grasp and lift different objects? How do we decide where to place our fingers?

If you are interested, just send an email to Roland.W.Fleming@psychol.uni-giessen.de.

Video zur AG von Prof. Dr. Roland Fleming

Representative Publications:

- Klein, L.*, Maiello, G.*, Paulun, V. C., & Fleming R. W. (2020). Predicting precision grip grasp locations on three-dimensional objects. PLoS Computational Biology, 16(8): e1008081. [* equal authorship]

- Phillips, F.*, & Fleming, R. W.* (2020). The Veiled Virgin illustrates visual segmentation of shape by cause. Proceedings of the National Academy of Sciences, 201917565. [* equal authorship]

- Van Assen, J. J., Nishida, S., & Fleming, R. W. (2020). Visual perception of liquids: Insights from deep neural networks. PLoS Computational Biology, 16(8): e1008018.

- Fleming, R. W., & Storrs, K. R. (2019). Learning to See Stuff. Current Opinion in Behavioral Sciences, 30: 100–108.

- Schmidt, F., Phillips, F., & Fleming, R. W. (2019). Visual perception of shape-transforming processes: ‘Shape Scission’. Cognition, 189, 167-180.

- Van Assen, J. J., Barla, P., & Fleming, R. W. (2018). Visual Features in the Perception of Liquids. Current Biology, 28(3), 452–458.

- Fleming, R. W. (2017). Material Perception. Annual Reviews of Vision Science, 3(1). 365-388.

- Schmidt, F., & Fleming, R. W. (2016). Visual perception of complex shape-transforming processes. Cognitive Psychology, 90: 48–70.

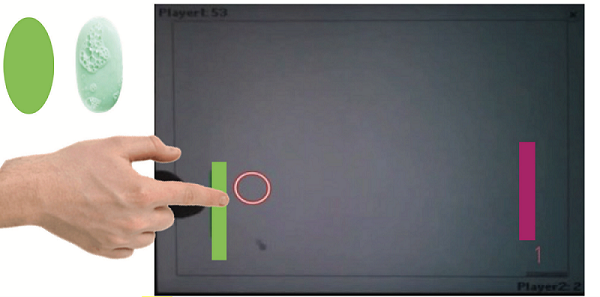

Verteilung von Aufmerksamkeit und Blick beim Computerspielen (Karl Gegenfurtner und Anna Schröger)

Wenn wir ein bewegtes Objekt, z.B. einen Ball betrachten, machen wir Vorhersagen darüber, was als nächstes passieren wird. Im Falle eines Balles sind dies beispielsweise Erwartungen darüber, ob der Ball seine Bewegung normal fortsetzt, auf eine Wand trifft und abprallt, oder von einer Person gefangen, weggeschlagen, oder anders abgelenkt wird.

Diese Vorhersagen basieren auf unserer Erfahrung mit der Umwelt. Aber was passiert nun, wenn sich die Bedingungen, unter denen wir Erfahrungen gesammelt haben, plötzlich ändern - wenn der Ball zum Beispiel einen Drall entwickelt, er weniger gut zu sehen ist (weil es dunkel geworden ist), oder wenn wir selbst anders mit ihm interagieren, beispielsweise mit feuchten Händen?

Solche Prozesse können wir untersuchen, indem wir die Blick- und Handbewegungen von Personen analysieren, die einen bewegten Gegenstand betrachten oder sogar mit ihm interagieren. Ähnliche Untersuchungen zeigen beispielsweise, dass Probanden einen Ball gleichmäßig mit ihrem Blick folgen können und mit Sakkaden an bestimmte Orte springen und fixieren, weil sie erwarten, dass dort etwas passieren wird (z.B., dass der Ball an dieser Stelle von der Wand abprallen wird). Diese prädiktiven (vorhersagenden) Augenbewegungen wollen wir nutzen, um zu verstehen, wie Probanden auf unerwartete Situationen reagieren und wie schnell sie sich an neue Bedingungen anpassen.

Um dies zu testen, wollen wir Probanden auf einem iPad ein Computerspiel („Pong“) spielen lassen und währenddessen die Eigenschaften des Balles, des Kontexts, oder der Interaktion des Spielers selbst mit dem Touchscreen manipulieren.

Bei Interesse senden Sie eine E-Mail an anna.schroeger@psychol.uni-giessen.de.

Repräsentative Publikationen:

- Chen J, Valsecchi M, Gegenfurtner KR (2016). Role of motor execution in the ocular tracking of self-generated movements. J Neurophysiol, 16(6):2586-2593.

- Fooken, J., Kreyenmeier, P., & Spering, M. (2021). The role of eye movements in manual interception: A mini-review. Vision Research, 183, 81-90.

Kontrolle von Augenbewegungen (Karl Gegenfurtner und Alexander Goettker)

Unsere Augen bewegen sich kontinuierlich und bieten einen direkten Zugang zur Verarbeitung von Informationen in unserem Gehirn: Was uns grade interessiert, das schauen wir uns auch an. Wie schnell und genau wir uns relevante Dinge angucken können, hängt von vielen Faktoren ab. Erfahrungen und Wissen können uns helfen interessante Objekte schneller zu finden, zusätzliche Information ermöglicht es, Bewegungen besser vorherzusagen und die Erwartung von Belohnung kann Prozesse beeinflussen und beschleunigen. Diese Mechanismen wollen wir untersuchen, indem wir die Augenbewegungen von Personen während verschiedener Aufgaben messen.

- Wie verändern sich Augenbewegungen basierend auf unseren Erfahrungen und Erwartungen? Schauen wir ein Video von einem Eishockeyspiel, können wir dem Spielgeschehen und dem Puck relativ gut mit den Augen folgen. Wie unterscheiden sich die Augenbewegungen jetzt aber, wenn wir die gleiche Bewegung des Pucks präsentieren, aber ohne den Kontext des Eishockeyspiels?

- Welche Rolle können erwartete Belohnungen bei der Bewegung unserer Augen spielen? Grundsätzlich wird unser Blick eher von auffälligen Objekten mit grellen Farben oder hohem Kontrast angezogen. Wie verändern sich jedoch unsere Blickbewegungen, wenn wir beispielsweise unauffällige Objekte präsentieren, die mit Belohnung assoziiert werden?

Video zur AG von Prof. Dr. Karl Gegenfurtner

Representative Publikationen:

- Dorr, M., Martinetz, T., Gegenfurtner, K. R., & Barth, E. (2010). Variability of eye movements when viewing dynamic natural scenes. Journal of vision, 10(10), 28-28.

- Kowler, E., Aitkin, C. D., Ross, N. M., Santos, E. M., & Zhao, M. (2014). Davida Teller Award Lecture 2013: The importance of prediction and anticipation in the control of smooth pursuit eye movements. Journal of vision, 14(5), 10-10.

- Schütz, A. C., Trommershäuser, J., & Gegenfurtner, K. R. (2012). Dynamic integration of information about salience and value for saccadic eye movements. Proceedings of the National Academy of Sciences, 109(19), 7547-7552

- Schütz, A. C., Braun, D. I., & Gegenfurtner, K. R. (2011). Eye movements and perception: A selective review. Journal of vision, 11(5), 9-9.

Farbwahrnehmung in Virtuellen Welten (Karl Gegenfurtner und Raquel Gil)

Unsere Farbwahrnehmung hängt nicht nur von der Zusammensetzung des Lichts ab, das von einem Objekt reflektiert wird und in unser Auge gelangt. Farbe hängt von der Verteilung des Lichts in der ganzen Szene ab. Unser visuelles System hat die herausragende Eigenschaft, an die vorherrschende Beleuchtung zu adaptieren und Objekten Farben zuordnen zu können, die invariant sind, also nur vom Objekt selbst abhängen. Virtual Reality bietet eine Möglichkeit, Objektfarben, Beleuchtungen und auch deren Interaktionen beliebig zu ändern und so herauszufinden, wie unser visuelles System Farbkonstanz ermöglicht. Wir benutzen dabei photo-realistische virtuelle Welten, mit denen die Probanden interagieren können.

Sie werden sich während im Rahmen ihrer Arbeit die Grundlagen der Farbwahrnehmung und der Farbkonstanz aneignen, mit der Technologie der Virtuellen Realität vertraut werden sowie psychophysische Messverfahren gründlich erlernen. Bei Interesse kontaktieren Sie bitte gegenfurtner@uni-giessen.de.

Video zur AG von Prof. Dr. Karl Gegenfurtner

Representative Publikationen:

- Witzel, C. & Gegenfurtner, K.R. (2018) Color perception: objects, constancy, and categories. Annual Review of Vision Science, 4, 475-499.

Helligkeit und Sättigung von Objekten (Karl Gegenfurtner und Laysa Hedjar)

Trotz eines hohen Grads an Standardisierung, die eine originalgetreue Wiedergabe der Farben von einzelnen Bildpunkten im Druck und auf Displays ermöglicht, ist noch nicht bekannt, welche Faktoren der Wahrnehmung von Helligkeit und Sättigung von ganzen Objekten unterliegen. Wir wollen dies sowohl mit Fotos von Objekten untersuchen als auch mit Objekten, die mittels Computergraphik generiert werden. Probanden schätzen die Helligkeit und Sättigung dieser Objekte ein und die Ergebnisse werden korreliert mit Eigenschaften der den Objekten entsprechenden Verteilungen von Farben und Intensitäten im Bild.

Sie werden sich während im Rahmen ihrer Arbeit die Grundlagen der Farbwahrnehmung aneignen, mittels Computergraphik (z.B. Blender) künstliche Objekte erzeugen sowie psychophysische Messverfahren gründlich erlernen. Bei Interesse kontaktieren Sie bitte gegenfurtner@uni-giessen.de.

Video zur AG von Prof. Dr. Karl Gegenfurtner

Representative Publikationen:

- Witzel, C. & Gegenfurtner, K.R. (2018) Color perception: objects, constancy, and categories. Annual Review of Vision Science, 4, 475-499.

Farbdarstellung in der Kunst (Karl Gegenfurtner und Doris Braun)

Während die obige Arbeit sich damit beschäftig, wie Farben tatsächlich in Objekten und Szenen verteilt sind, geht es bei dieser Arbeit darum, zu erforschen, wie Künstler die Darstellung der Farbe von Objekten optimieren. Wir werden in digitalen Kunstsammlungen Fotos von Obst in Stillleben in Hinblick auf deren Farbe analysieren. Gleichzeitig geben Probanden Urteile über Helligkeit und Sättigung der Farben ab, die dann mit den Merkmalen der Farbverteilungen in den Gemälden verglichen werden.

Sie werden sich während im Rahmen ihrer Arbeit die Grundlagen der Farbwahrnehmung aneignen, digitale Bilder am Computer bearbeiten (z.B. Adobe Photoshop) und deren Farben analysieren, sowie psychophysische Messverfahren gründlich erlernen. Bei Interesse kontaktieren Sie bitte gegenfurtner@uni-giessen.de.

Video zur AG von Prof. Dr. Karl Gegenfurtner

Representative Publikationen:

- Braun, D. I., & Doerschner, K. (2019). Kandinsky or Me? How Free Is the Eye of the Beholder in Abstract Art? i-Perception, 10(5), 2041669519867973.

- Witzel, C. & Gegenfurtner, K.R. (2018) Color perception: objects, constancy, and categories. Annual Review of Vision Science, 4, 475-499.

Individuelle Unterschiede in der visuellen Wahrnehmung (Ben de Haas)

Die funktionale Architektur des menschlichen Sehsystems löst nur die Teile einer Szene klar auf, die wir direkt anschauen; Objekte in der Peripherie sind schwer auseinanderzuhalten. Daher ist die visuelle Wahrnehmung ein aktiver Prozess - wir müssen ständig unsere Augen bewegen, um visuelle Objekte von Interesse zu fixieren.

Computergestützte "Salienzmodelle" versuchen vorherzusagen, welche Teile eines gegebenen Bildes fixiert werden. Wir haben jedoch kürzlich festgestellt, dass Fixationsziele nicht nur eine Funktion des Bildes, sondern auch des einzelnen Beobachters sind. Beobachter, die komplexe Szenen frei betrachten, unterscheiden sich systematisch in der Neigung, bestimmte visuelle Objekte zu fixieren. Zum Beispiel werden die Augenbewegungen einiger Menschen besonders stark von Gesichtern in einer Szene angezogen, während andere mehr auf Textelemente schauen als andere.

Wir werden weitere Verhaltens- und Eyetrackingexperimente durchführen, um die Ursachen und Folgen solcher individuellen Unterschiede besser zu verstehen. Aktuell untersuchen wir zum Beispiel, inwieweit individuelle Unterschiede im Blickverhalten mit Unterschieden in der Beschreibung beobachteter Szenen einhergehen. Bei Interesse können Sie sich per E-Mail an benjamindehaas@gmail.com wenden.

[Wenn Sie mit Dr. de Haas die Aufnahme einer Abschlussarbeit in seiner Arbeitsgruppe vereinbart haben, kreuzen Sie auf dem Wahlzettel bitte "Karl Gegenfurtner" an - wir teilen Sie dann zu]

Representative papers:

- De Haas, B., Iakovidis, A. L., Schwarzkopf, D. S., & Gegenfurtner, K. R. (2019). Individual differences in visual salience vary along semantic dimensions. Proceedings of the National Academy of Sciences, 116(24), 11687-11692.

- Constantino, J. N., Kennon-McGill, S., Weichselbaum, C., Marrus, N., Haider, A., Glowinski, A. L., ... & Jones, W. (2017). Infant viewing of social scenes is under genetic control and is atypical in autism. Nature, 547(7663), 340.

- Kennedy, D. P., D’Onofrio, B. M., Quinn, P. D., Bölte, S., Lichtenstein, P., & Falck-Ytter, T. (2017). Genetic influence on eye movements to complex scenes at short timescales. Current Biology, 27(22), 3554-3560.

- Xu, J., Jiang, M., Wang, S., Kankanhalli, M. S., & Zhao, Q. (2014). Predicting human gaze beyond pixels. Journal of vision, 14(1), 28-28.